|

|||||||||

その105「MIDIの原理とSMFの構造」 |

|||||||||

|

■ MIDIって何? 端的に言えば、MIDIは異なるメーカーの楽器であっても、同一のインターフェイスで接続して連動できるようにしよう、というものです。Specificationは、MMAから「Complete MIDI 1.0 Detailed Specification」として入手できます。最新版は2001年11月にまとめられた「Version 96.1 Second Edition」で、良くぞここまで改定したというべきか、名前の付け方を変えた方が良かったんじゃないかと、いろいろ考えさせられます。 MIDI自体は、5pinのDIN端子を使い、31.25kbpsの速度で演奏データを転送するものです。MIDI Specificationでは、物理的なケーブルの形状や通信方式、実際の演奏データフォーマットなどをすべて網羅したものになっています。 さて、MIDI自体はインターネットとあまり関係がありません。もともとMIDIは、スタジオや(大きくても)コンサートホールレベルのエリアに配される、シンセサイザなどの機器を接続するための規格です。もっとも最近は接続すべき機器類が非常に多くなり、接続も段々難しくなってきたため、「MIDI over LAN」や「ipMIDI」というようにTCP/IPの上にMIDIプロトコルを通すなんて方式も次第に広まってきました。しかし、流石にこれでインターネットを介するというのは技術的にはともかく、実際はあまり意味はありません。 では、インターネットに関係するものはというと、MIDI規格のうち、「SMF(Standard MIDI File)」と呼ばれるものがあてはまります。SMF自体はもともと、Opcode System社が提唱したMIDIデータを格納するための規格です。もちろん、これも当初はPCにMIDI機器を接続して演奏したり、逆に演奏データをPCに格納したりするためのものでしたが、音楽データをMIDIフォーマットで交換するという用途でも当然使用されています。加えて、インターネット上においてMP3などに比べればややシェアは低いものの、それなりに使われているのが現状です。 ■ MIDIの原理とSMFの構造

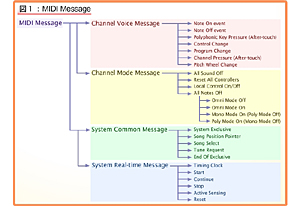

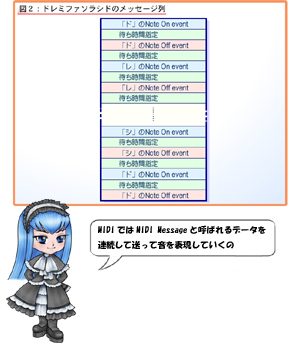

最初に音色とか速度などのデータを送った後は、音符同様に音程や音のオン・オフがシーケンシャルに送られ、MIDI機器はこれを元に内蔵する音源の音色を使って再生(演奏)を行なう形になります。具体的に言えば、MIDIでは「MIDI Message」と呼ばれるデータを連続して送る形になります。どんなMessageが用意されているかをまとめたのが図1ですが、この中で1番頻繁に使うのが上の2つ、「Note On」と「Note Off」というイベントです。 例えば、「ドレミファソラシド」を演奏させたい場合に、MIDIでは図2のようなメッセージ列を送る形になります。Note Onというのはピアノで言えばキーを押す指定、Note Offはキーを離す指定になります。それぞれ待ち時間がその後に入っているので、これを調整することで「ドッレッミッファッソッラッシッドッ!」にも、「ド~レ~ミ~フ~ァ~ソ~ラ~シ~ド~」にも調整できるわけです。本稿の意図はMIDIのフォーマットの詳細を説明するものではないので、このあたりで説明はやめておきますが、譜面では感覚的に表現するような項目も、MIDIではデータとして表現するというわけです。

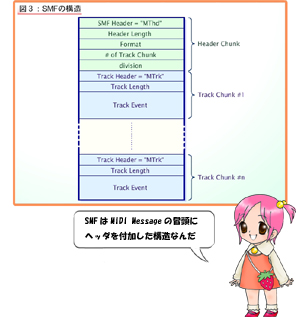

SMFは、このMIDIメッセージ列の頭にヘッダをつけるだけの構造です。厳密に言えばメッセージ列のことをMIDIでは「トラック」というのですが、図3のように簡単な「ヘッダ(Header Chunk)」の後ろに、ずらずらと「トラック(Track Chunk)」が繋がるという構造です。何故、Track Chunkが複数あるのかという話ですが、MIDIでは1つのTrackで1度に発音できる音は1つだけになるからです。 従って、「ドミソ」を同時に発声させたければ、3トラック必要になるというわけです。何か無駄のように感じるかもしれませんが、例えば長い曲の1カ所だけが和音というケースではTrack Chunk #1にメロディを入れ、Track Chunk #2以降は和音の前後は全休符にしておけば良いので、それほど無駄が多いというわけではなかったりします。

■ MIDIの長所・短所と発展形 また、音声データにしても、例えば図2のドレミファソラシドの場合、メッセージ列そのものは78バイト(Note On/Offが各3バイト、待ち時間指定が各2バイト)で済みます。実際には「Header Chunk(14バイト)」と「Track Chunk Header/Track Length(8バイト)」、それにTrackの最後に「EOT(End Of Track)の宣言(4バイト)」を追加するために104バイトほどになりますが、それでもたったの104バイトです。22KHz/16bit MonoのWAVだと0.002秒分、64kbpsのMP3でも0.013秒分にしかならないデータ量でこれだけの曲を表現できるのですから、その効率の良さは圧倒的といってよいでしょう。 もう1つのメリットは、非常に広い範囲でサポートされている点です。PC(Windows/Macintosh/Linuxを問わず)のメディアプレーヤーでMIDI(というか、SMF)をサポートしていないものは数えるほどですし、電子楽器の大半は当然サポートしています。メディアプレーヤーどころか、Webブラウザレベルでサポートしているものもあるほどなので、曲の配布などをするときに相手の環境にあまり悩まずに済みます。 では短所はというと、実はこれも何点か存在します。まず最大の問題は、音声をサポートしていないこと。何しろ譜面ですから、これを使って会議の録音などをするわけにはいきません。あくまでサポートしているのは“曲”、それも西洋音階に従った曲のみであり、ボーカルパートなども記録や再生はできません。 次の問題は「音色」。MIDIには標準的な128種類の音色が定められており、これに従えば同じ音が出るハズなのですが、例えば音色の1番のグランドピアノにしても、どこのメーカーのどんなグランドピアノも全部同じ音がするかと言えば、そんなことはないわけです。もっと悪いことに、MIDIでは音色1番は単に「グランドピアノ」と決められているだけで、その音色が具体的に定まっているリファレンスがあるわけではありません。結果、MIDIを作る側と再生する側で異なる音色が割り当てられる場合もあり、MIDIでは“曲が一緒”であることは保証されますが、“音が一緒”とは誰も保証して(できて)いません。 3つ目の問題は、再生側の環境で音が変わってしまうことが多々あることです。最近はPCのハードウェア性能が向上し、「HDA(High Definition Audio)」と呼ばれる規格に準拠したものが増えました。しかし、少し前では「AC97(Audio Codec 97)」と呼ばれる規格に準拠したものが多く、こちらでは同時に32音まで、また、酷いものになると16音までしか発音できないなんてものが平気で流通していました。 ドレミファソラシド程度なら16音でもお釣りがきますが、オーケストラクラスとまではいかなくても、ちょっとしたバンドの演奏程度で簡単に16音は越えてしまいます。越えた場合どうなるかというと、単に無視されて音が出ないわけで、結果として妙にすかすかした演奏になってしまいます。この同時発音数の問題は、ソフトウェアMIDIプレーヤーを使っていると、今も出会うケースがあります。 結果として、ちょっとしたBGMの再生などにはともかく、生音声の記録や配布には向いていないのがMIDIフォーマットというわけです。筆者がインターネット上で良く見かける使い方は、曲そのものを説明するときに、いろいろ書くよりは聞いたほうが早いというパターンです。 例えばクラシック曲の場合、曲自体は著作権が切れていますが、オーケストラなどが演奏したものは演奏者の著作権もありますし、CDであればCD発売元の権利もありますから、勝手に配布はできません。しかし、自分で譜面からMIDIを起こせば著作権の心配もなく配布できるというわけです。また、自分のページでBGMを流したい、というケースにもデータが小さいこともあり、手軽に利用されているようです。MIDI自体は、演奏やカラオケなどで非常に広く利用されていますが、インターネットに絡むところでは今一歩という感じでしょうか? ところでこのMIDIを拡張したものの1つが「SMAF」です。着メロなどにもMIDIの持つ特性は非常に向いており、こうした形でのMIDIの応用は今後も続いていくと思われます。 【12月18日17時35分追記】 掲載後にいくつかご指摘をいただいたので、ちょっと補足説明をしておきます。 (1)和音について 本文では、「MIDIでは1つのTrackで1度に発音できる音は1つだけになります。」と書きましたが、これの意味があやふやな部分がありました。MIDIで和音を作る場合、以下の2種類の方法があります。 ・待ち時間0で音を重ねる ・複数トラックで同時に音を出す 後者は上で説明した通りなので、前者について少し補足しておきます。例えば、「ドミソ」の和音を鳴らしたいときに、以下のようなメッセージ列を送ったとします。 「ド」のNote On event 待ち時間=0 「ミ」のNote On event 待ち時間=0 「ソ」のNote On event 待ち時間=いくらか 「ド」のNote Off event 待ち時間=0 「ミ」のNote Off event 待ち時間=0 「ソ」のNote Off event この場合、耳で聴く限り、「ドミソ」の和音がいきなり鳴らされたかのように聴こえます。この意味においては、シングルトラックでも“事実上は”和音が作れます。ただ、厳密に言えば、微妙なタイムラグはあります。この例で言えば、「ド」の音が発生してから「ソ」の音が重なるまでの間に、4つのMIDI命令を解釈する必要があります。 解釈自体の時間は非常に短いので、ある程度まともなシンセサイザーであれば気が付かないないでしょうが、例えば和音の数が非常に多いケースや、いい加減な作りのソフトウェアシンセサイザーで再生した場合には、タイムラグが知覚できてしまったりします。 ファイルなどから読み込むSMFではこうした問題はあまり問題になりにくいのですが、オリジナルのMIDIケーブル経由で接続していると、何しろ通信速度は31.25kbps(=4000Bytes/sec)ですから、環境次第では結構シビアになります。 こうした場合でも確実に和音が和音として再生されるための唯一の方法は、複数トラック構成ということになります。そういうわけで冒頭の表現、正確には「MIDIでは1つのTrackで1度に操作できる音は1つだけになります。」となります。むしろ、わかりにくくなった気はするのですが、正確さを優先するということで、お詫びして訂正いたします。 (2)16音でお釣りがくる 「ドレミファソラシド程度なら16音でもお釣りが来ます」という表現の意味がわからない、というメールをいただいたので補足を。特に深い意味はなく、単に該当部分の説明のような単調な音(その例が「ドレミファソラシド」という意味です)だけを再生するのであれば、同時発声数が16程度の環境であっても、なんら不自由はない、というだけの意味です。言葉足らずをお詫びいたします。 2006/12/18 10:58

|

| Broadband Watch ホームページ |

| Copyright (c) 2006 Impress Watch Corporation, an Impress Group company. All rights reserved. |